0-Generalized SAM: Efficient Fine-Tuning of SAM for Variable Input Image Sizes

Generalized SAM:用于可变输入图像尺寸的 SAM 高效微调

arXiv:2408.12406v1 [cs.CV] 22 Aug 2024

背景

深度学习在图像识别领域成果斐然,基础模型虽具强大泛化能力,但在特定任务中需微调。SAM 作为图像分割基础模型,零样本性能佳,可对自然图像高精度分割,但识别任意类别时需微调,其固定 1024×1024 的输入图像尺寸,致使微调计算成本高昂,且易造成图像信息丢失。

尽管已有如 LoRA、AdaptFormer 等 SAM 微调方法,但均未解决输入图像尺寸固定问题。部分方法虽可降低输入尺寸,但仍需固定,面对不同像素数数据集,易丢失图像信息,影响分割效果与效率。

所以作者提出广义 SAM(GSAM),实现 SAM 训练时输入图像尺寸可变,首次在 SAM 训练中应用随机裁剪,降低计算成本,同时保持分割性能,通过位置编码生成器(PEG)和空间多尺度(SM)AdaptFormer 等结构优化微调过程。

实验方法

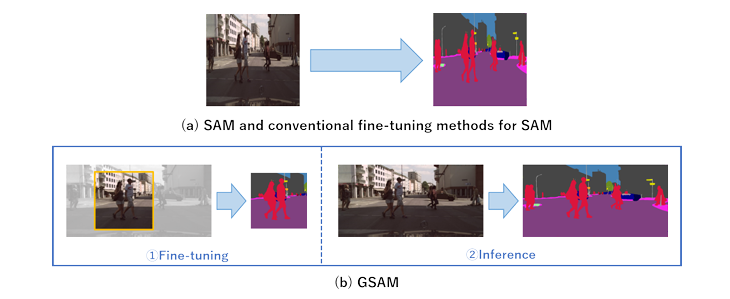

当使用传统方法对 SAM 进行语义分割微调时,只能输入固定大小的图像。因此,输入图像会变形以适应特定大小,从而导致信息丢失。相比之下,GSAM 支持各种输入图像大小,同时保持 SAM 卓越的分割性能。这允许图像以其原始形式使用,并支持在微调期间进行随机裁剪,这在以前与 SAM 相关的方法中是不可用的。GSAM 提供高效的微调,专门用于任意数据的语义分割,最大限度地减少信息损失和计算成本。

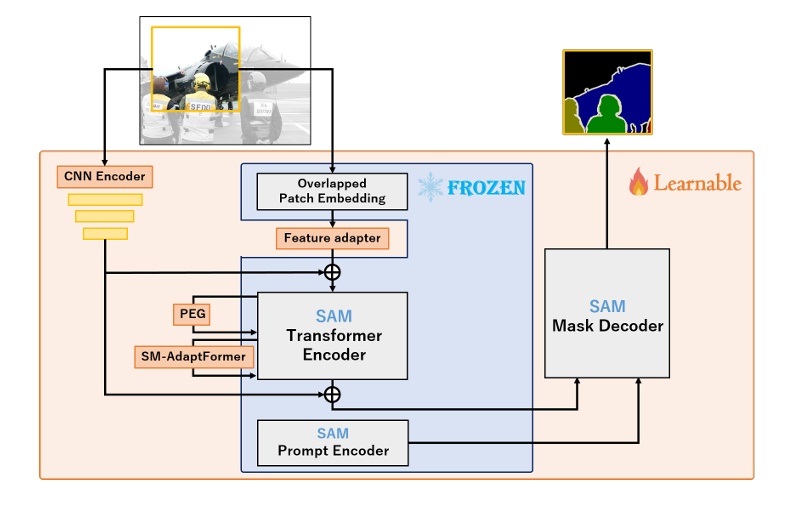

FROZEN 表示权重参数固定的网络,Learnable 表示权重参数更新的网络。

训练中随机裁剪

SAM 因位置编码固定而需固定输入尺寸,GSAM 采用由深度可分离卷积层构成的 PEG 替代,其仅考虑空间方向,使特征图输入尺寸可变时仍保留位置信息。

鉴于 SAM 对小且可变输入的自注意力全局学习可能不足,引入由 CNN 组成的新网络(CNN Encoder),整合 CNN 与 SAM 特征。GSAM 将 ResNet101 第三块特征图加入 SAM 编码器前后,实现随机裁剪下的高效微调。

空间多尺度 AdaptFormer

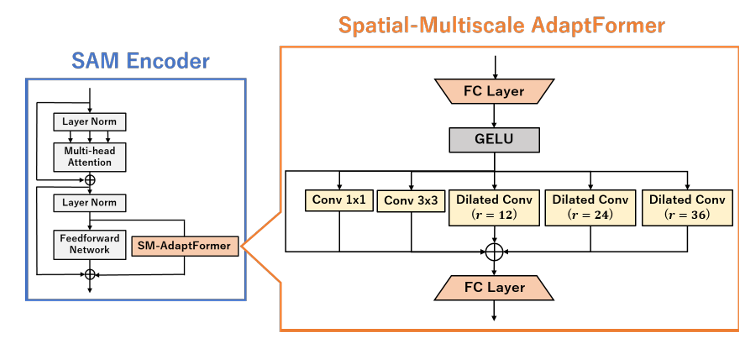

空间多尺度 AdaptFormer 概述。使用具有不同感受野的五个卷积层来获取语义分割所需的空间特征。

为提升对目标数据集判别精度,提出 SM - AdaptFormer。鉴于 AdaptFormer 未考虑空间信息,而其在语义分割中至关重要,SM - AdaptFormer 设多尺度卷积层获取多尺度特征。

采用扩张卷积扩大感受野、降低计算成本,设 1×1、3×3 卷积层及不同扩张率的扩张卷积层(r = 12、24、32)获取多尺度特征,经相加学习,且在全连接层保持低维输入,避免计算冗余。

实验结果

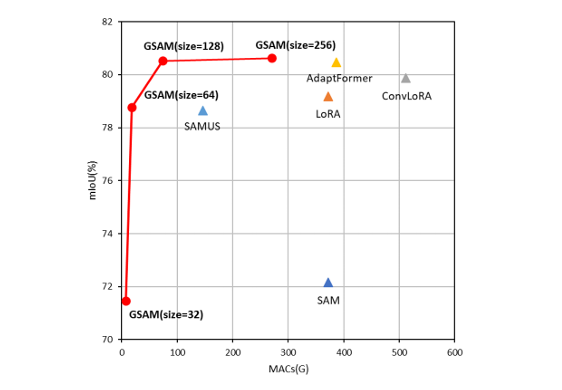

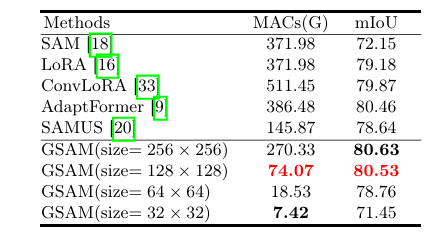

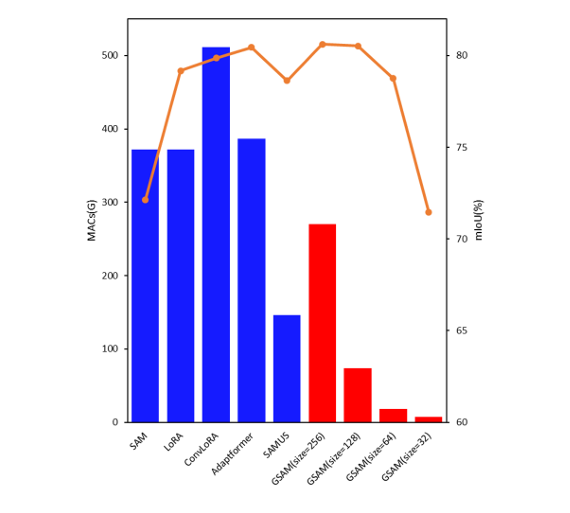

在 ISBI2012 数据集上 SAM 的传统微调方法中,MAC 和分割精度 (mIoU) 之间的权衡 [15]。红色圆圈表示提出的 GSAM,三角形表示传统方法。仅对 GSAM 执行随机裁剪,裁剪为“size”指示的像素数。由于其结构,除 GSAM 外,不能使用随机裁剪。

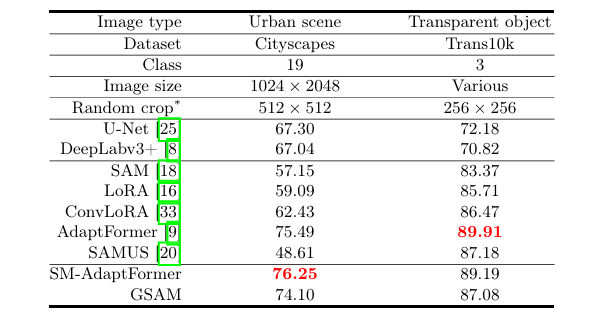

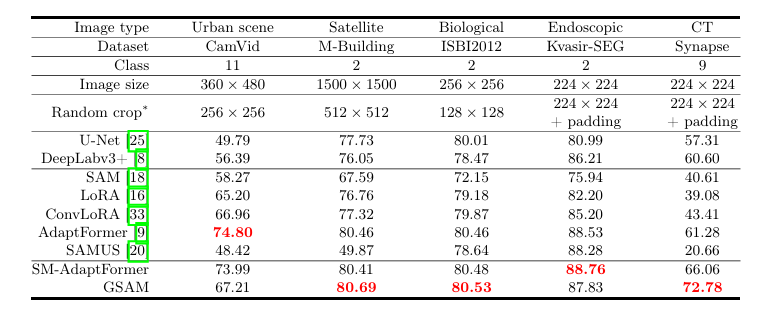

数据集和指标

使用车载、卫星、显微、内镜、CT 和透明物体等多种领域图像数据,含两个超万张图像的大数据集(Cityscapes 和 Trans10k)及五个千张以下小数据集(CamVid、Massachusetts Buildings、ISBI2012、Kvasir - SEG、Synapse 多器官数据集),以平均交并比(mIoU)为评估指标。

训练条件

基于 Pytorch,用 Adam 优化器训练 200 个 epoch,批次大小为 8,学习率 0.005 并余弦退火调整。对比 U - Net、DeepLabv3 + 等 CNN 网络及 LoRA、ConvLoRA、AdaptFormer、SAMUS 等 SAM 微调方法。

数据预处理时,CNN 方法和 GSAM 采用随机裁剪、水平翻转与旋转(车载和透明物体图像不旋转),其他方法因固定尺寸仅用后两者。各数据集随机裁剪尺寸依自身特性确定。

定量结果

在各数据集,GSAM 精度与现有 SAM 微调方法可比或更高。多数数据集里,SM - AdaptFormer 和 GSAM 精度领先,如在 Synapse 多器官数据集,较 AdaptFormer 分别提升 4.78% 和 11.50%。

部分数据集(Trans10k 和 CamVid)中 AdaptFormer 精度最高,SM - AdaptFormer 次之。这与数据集对象大小、类别数量及扩张卷积设置有关,而 GSAM 支持可变输入尺寸优势独特。整体而言,GSAM 因结合 SM - AdaptFormer、SAM 优势及随机裁剪,精度优于 CNN 网络45。

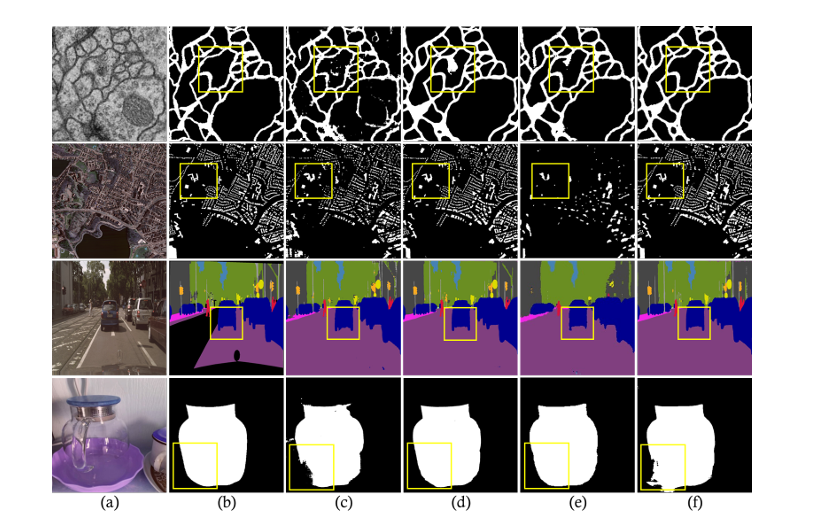

定性结果

在含精细结构和小对象数据集(ISBI 和 M - Building),GSAM 相比其他 SAM 微调方法优势显著,可减少细胞膜类过检测、精准分割复杂小对象在类别多样或含大对象数据集(Cityscapes 和 Trans10k),GSAM 未显优势,可能因 SM - Adaptformer 扩张卷积率固定不适配,且多尺度特征提取对仅含大对象数据集效果不佳。

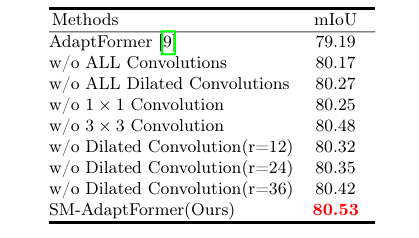

消融研究

SM - Adaptformer 有效性:对其消融研究表明,各尺度卷积层对提升分割精度贡献显著,标准卷积与扩张卷积皆有效。相比仅含耦合层与激活函数的 AdaptFormer,SM - Adaptformer 因多尺度空间信息获取能力更强而更优,尤其适用于对象大小范围广的数据集。

效率:对比 SAM、LoRA 等方法,随随机裁剪尺寸减小,GSAM 计算成本指数级降低。如输入 128×128 时,精度超传统方法且计算成本约为 SAMUS 一半。尽管 SM - Adaptformer 结构复杂,但 PEG 和 CNN 支持可变输入使成本大减,有望成 SAM 高效微调途径。

说明了 ISBI2012 数据集上每种方法的 MAC 和分割精度。条形图是每种方法的 MAC,折线图是 mIoU。

总结

提出的 GSAM 可处理 SAM 可变输入图像尺寸,首次在训练中用随机裁剪降成本、提效率、保精度,优于传统 SAM 微调方法。未来拟解决 SM - Adaptformer 扩张卷积率固定问题、增通用性,考虑在 SAM 解码器加 LoRA 结构提升训练效率。