0-Diffusion Models Beat GANs on Image Synthesis

Diffusion Models Beat GANs on Image Synthesis

发表在2021年的NeurIPS会议上

背景

GANs(生成对抗网络)一直是广泛使用的方法之一,在图片生成领域效果很好,但也有着训练过程不稳定,模式崩溃等问题。Diffusion Models(扩散模型)是一类基于概率生成过程的模型,一开始用于密度建模和生成任务,此研究旨在评估扩散模型在图像生成任务中的表现,与GANs进行对比。扩散模型有着分布覆盖广,使用静态训练目标和易于扩展的有点,但是其生成效果与GANs仍然有差距,所以作者改进了现有的Diffusion模型架构,同时提出了可以平衡图像生成多样性和逼真度的方案。

实验方法

论文提出了一种改进的扩散模型,该模型通过多步去噪过程生成高质量的图像。扩散过程包括两个阶段:

- 前向过程:逐渐向图像中添加噪声,直到图像变成纯噪声。

- 反向过程:从纯噪声开始,逐步去噪重建图像。

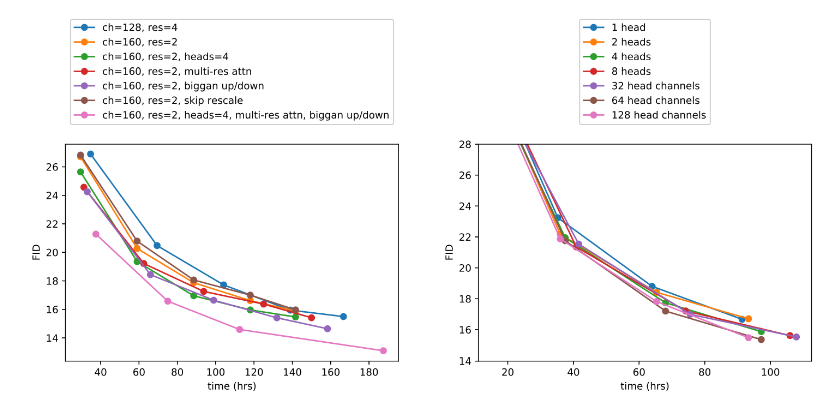

研究中使用了特定的网络结构和训练策略来优化扩散模型的性能,包括了U-Net架构、阶梯式噪声调度策略等,经过改进后,模型取得了明显的效果。

实验结果

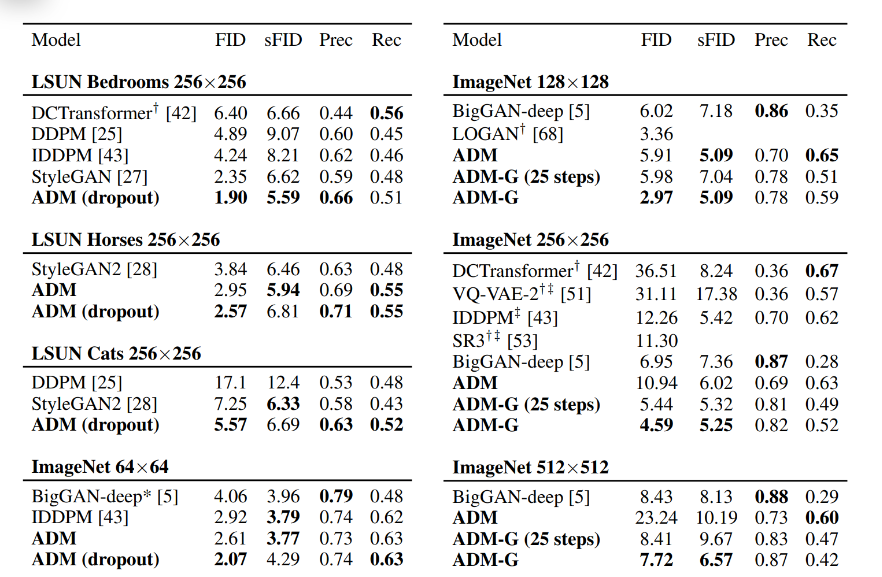

论文在多个数据集上对扩散模型和GANs进行了实验对比,包括CIFAR-10、LSUN、ImageNet等。实验结果表明,扩散模型在图像生成的质量和多样性上优于GANs。具体表现为:

- 在CIFAR-10上,扩散模型生成的图像质量(FID值)优于当前最好的GAN模型。

- 在更大规模的ImageNet数据集上,扩散模型也展示了优异的生成能力。

结论

论文的主要贡献在于提出并验证了扩散模型在图像生成任务中的优越性,表明这种模型在图像质量和生成稳定性上都超过了传统的GANs。未来的发展方向可能包括进一步优化扩散模型的效率,探索其在更大规模数据集和更复杂图像生成任务中的应用。