0-Improving neural networks by preventing coadaptation of feature detectors

Improving neural networks by preventing co-adaptation of feature detectors

arXiv:1207.0580v1 2012 06

背景

简而言之 Dropout 的提出,用于解决神经网络在训练过程中的过拟合问题,提升模型在测试集上的泛化能力。

Dropout 就是在每个训练步骤中,随机忽略(即“丢弃”)一部分神经元,使得网络不能依赖特定的神经元来进行特征检测,从而减少联合适应模式的发生。其原因就是神经网络中的神经元容易形成复杂的联合适应模式(co-adaptation),这种模式可能导致模型在训练数据上的表现很好,但在新数据上的表现较差。

过拟合已存在许久,之前也尝试过用诸如L2正则化、L1正则化等方式去解决这个问题,这些方法可以减少过拟合,但对于非常深的网络,其效果可能不如预期,或者增加大量的存储和计算成本。Dropout作为一种随机正则化技术,通过在训练过程中随机忽略一部分神经元,有效地防止了神经元之间的联合适应,显著提升了模型的泛化能力。

实验方法

- 在每次前向传播过程中,对于每个神经元,以一定的概率$p$决定是否将其暂时移除(即设为0)。

- 在训练过程中,每次随机选择的被忽略神经元集不同。

- 在测试过程中,使用整个网络,但每个神经元的输出按训练中被忽略的概率$p$进行缩放,以反映训练时的期望输出。

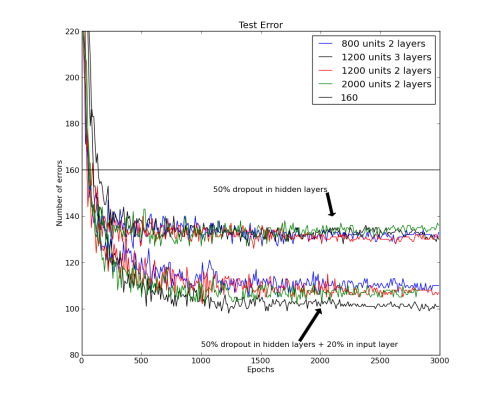

在MNIST数据集,什么都没有用在MNIST没有dropout时160个错误,50%的dropout得到130个错误,在输入加入20%的dropout得到110个错误。可以看到,输入一定量的dropout可以有效减少错误率。

实验结果

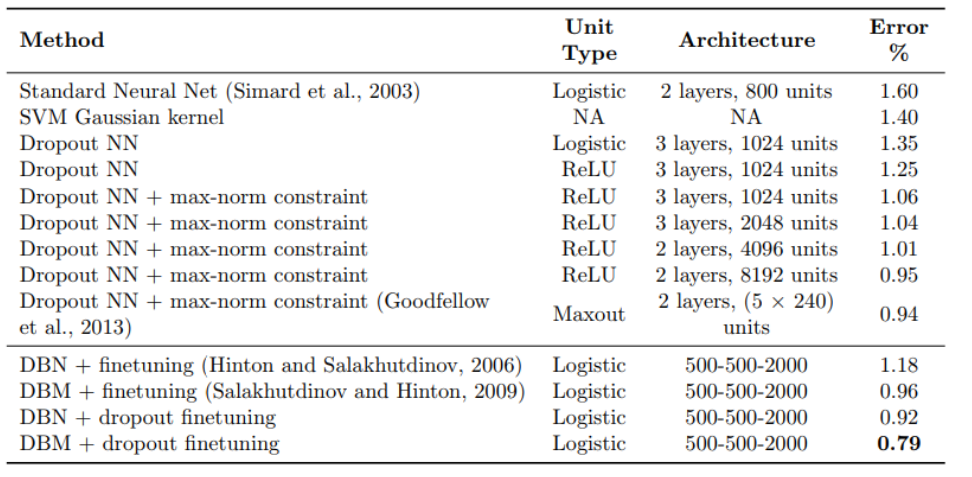

MINIST数据集

28*28的手写数字图像,10分类,6万训练集,1万测试集

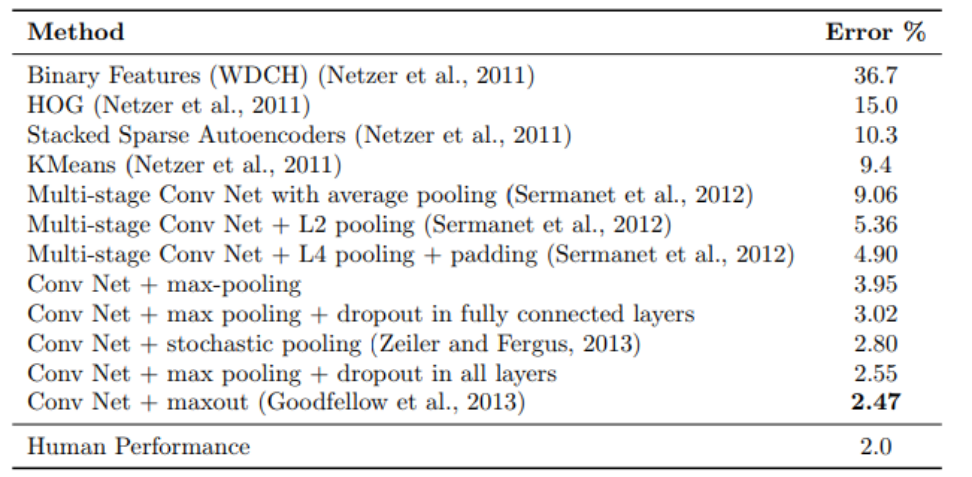

SVHN数据集

32*32*3的房子门牌号图像,识别房子门牌号,60万训练集,2万6测试集

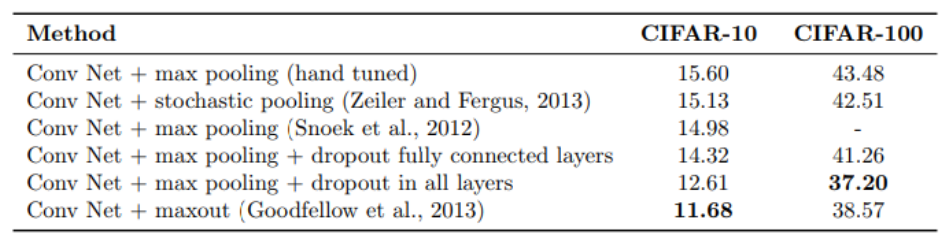

CIFAR-10/CIFAR-100数据集

32*32*3的现实图像,10分类和100分类,5万训练集,1万测试集

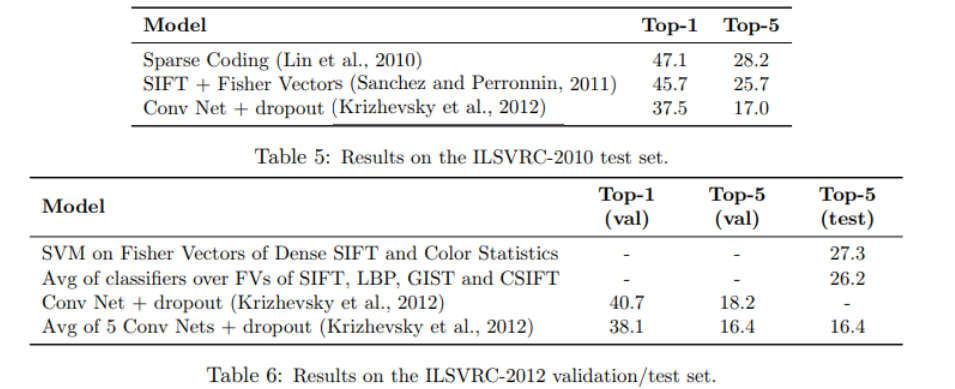

ImageNet数据集

与其他正则化方法比较

在多个数据集上的实验结果显示,使用Dropout的神经网络在分类任务中的错误率显著降低。Dropout已成为神经网络训练中常用的正则化技术,被广泛应用于各种深度学习模型中,如卷积神经网络(CNN)和循环神经网络(RNN)。

总而言之,本文的主要贡献为:

- 防止过拟合:通过Dropout,网络变得更加鲁棒,不容易过拟合训练数据,提升了在测试数据上的表现。

- 提高泛化能力:Dropout通过减少神经元间的联合适应模式,使得网络对不同特征的依赖更加平均,从而提高了模型的泛化能力。

- 简单有效:Dropout是一种简单但非常有效的正则化技术,不需要对网络结构进行复杂的修改。

总结

通过引入Dropout技术,有效防止了神经元间的过度联合适应,显著提升了神经网络的泛化能力和性能。Dropout的简单实现和显著效果,使其成为深度学习领域的重要技术。Dropout技术对深度学习的研究和应用产生了深远的影响,推动了更鲁棒、更高效的神经网络模型的发展。